- Saved searches

- Use saved searches to filter your results more quickly

- License

- mohdforever/GpuTest

- Name already in use

- Sign In Required

- Launching GitHub Desktop

- Launching GitHub Desktop

- Launching Xcode

- Launching Visual Studio Code

- Latest commit

- Git stats

- Files

- README.md

- About

- Gpu stress test linux

- 2. GLMark2 от команды разработчиков проекта Linaro

- 3. Тест Furmark утилиты GPUTest от команды ресурса geeks3d

- Perform GPU, CPU, and I/O stress testing on Linux

- Install stress, htop, and iotop

- Install and run gpu-burn

- Monitor with htop, nvidia-smi, and sensors.

- Read On

- Lambda Echelon – a turn key GPU cluster for your ML team

- NVIDIA A40 Deep Learning Benchmarks

Saved searches

Use saved searches to filter your results more quickly

You signed in with another tab or window. Reload to refresh your session. You signed out in another tab or window. Reload to refresh your session. You switched accounts on another tab or window. Reload to refresh your session.

GPU stress test and OpenGL benchmark

License

mohdforever/GpuTest

This commit does not belong to any branch on this repository, and may belong to a fork outside of the repository.

Name already in use

A tag already exists with the provided branch name. Many Git commands accept both tag and branch names, so creating this branch may cause unexpected behavior. Are you sure you want to create this branch?

Sign In Required

Please sign in to use Codespaces.

Launching GitHub Desktop

If nothing happens, download GitHub Desktop and try again.

Launching GitHub Desktop

If nothing happens, download GitHub Desktop and try again.

Launching Xcode

If nothing happens, download Xcode and try again.

Launching Visual Studio Code

Your codespace will open once ready.

There was a problem preparing your codespace, please try again.

Latest commit

Git stats

Files

Failed to load latest commit information.

README.md

GPU stress test and OpenGL benchmark Geeks3D GpuTest — GPU stress test and OpenGL benchmark. Copyright (c) 2012-2014 Geeks3D, All rights reserved.

THIS SOFTWARE IS PROVIDED ‘AS-IS’, WITHOUT ANY EXPRESS OR IMPLIED WARRANTY. IN NO EVENT WILL THE AUTHOR BE HELD LIABLE FOR ANY DAMAGES ARISING FROM THE USE OF THIS SOFTWARE.

1 — Unzip the archive where you want.

2 — Open a terminal in GpuTest folder.

3 — Launch a test by typing for example: $ sh ./start_furmark_windowed_1024x640.sh or $ sh ./start_tessmark_benchmark_fullscreen_1920x1080.sh

A GUI (graphical user interface made with Python / tkinter) is available since GpuTest 0.6.0+. To launch the GUI, run the following command:

$ python gputest_gui.py #for python2 or $ python3 gputest_gui.py #for python3

Under some Linux distributions, you might need to install the Tk package otherwise you will have:

Traceback (most recent call last): File «madshaders.py», line 4, in import Tkinter as tk # gives tk namespace File «/usr/lib/python2.7/lib-tk/Tkinter.py», line 42, in raise ImportError, str(msg) + ‘, please install the python-tk package’ ImportError: No module named _tkinter, please install the python-tk package

To install the python-tk package, just enter in command line:

$ sudo apt-get install python-tk or $ sudo apt-get install python3-tk

GpuTest Linux, random notes

- If needed, you can change the permissions of GpuTest.exe to make it executable: $ chmod u+x GpuTest.exe

- GpuTest 0.7.0 for Linux has been compiled under Linux Mint 16 64-bit with gcc version 4.8.1 (Ubuntu/Linaro 4.8.1-10ubuntu9).

- GpuTest 0.5.0 for Linux has been compiled under Linux Mint 15 64-bit with g++ 4.7.3 (Ubuntu/Linaro 4.7.3-1ubuntu1).

- All command line parameters can be found here: http://www.geeks3d.com/forums/index.php/topic,3092.0.html

About

GPU stress test and OpenGL benchmark

Gpu stress test linux

Библиотека сайта rus-linux.net

GLXGears с открытым исходным кодом является частью пакета утилит Mesa для тестирования поддержки технологии OpenGL и доступна в составе пакета программного обеспечения mesa-utils в дистрибутивах Debian/Ubuntu. Она может использоваться в качестве самодостаточного инструмента для тестирования производительности графического ускорителя и выводит число кадров в секунду (FPS) сразу же после запуска с помощью следующей команды:

sudo apt-get install mesa-utils glxgears

Число кадров в секунду не будет превышать 60, но производительность любого приложения, работающего с трехмерной графикой, может быть значительно улучшена в случае его запуска с переменной окружения vblank_mode=0 ; в моем случае удалось получить значение, равное 6000 кадрам в секунду при использовании графического ускорителя Intel HD 3000.

2. GLMark2 от команды разработчиков проекта Linaro

Это еще одна популярная утилита с открытым исходным кодом, предназначенная для стресс-тестирования и тестирования производительности графических ускорителей, которая была создана на основе исходного кода утилиты GLMark . Она доступна на платформах Linux и Android.

В официальных репозиториях дистрибутива Ubuntu размещены бинарные пакеты программного обеспечения с компонентами утилиты GLMark2, поэтому при ее установке в Ubuntu или любом производном дистрибутиве не должно возникнуть никаких проблем. Достаточно выполнить следующую команду для установки ее новейшей версии:

sudo apt-get install glmark2

К сожалению, бинарные пакеты с компонентами GLMark2 не добавлены в репозитории дистрибутива Debian, но вы в любом случае можете скомпилировать новейшую версию GLMark2 для дистрибутива Debian самостоятельно , после чего просто установить ее в систему.

Тестирование: теперь нужно просто выполнить команду glmark2 с помощью терминала, в результате чего откроется окно со стандартным разрешением 800×600 пикселей, в котором будут отображаться различные трехмерные объекты, такие, как фигурка лошади, кота, кролика и так далее. Процесс тестирования может растянуться на 8 минут, после чего будут выведены результаты тестирования. В моем случае графический ускоритель Intel HD 3000 набрал около 1000 баллов.

Стресс тестирование графического ускорителя: для работы GLMark2 требуется достаточное количество ресурсов графического процессора, поэтому зацикливание процесса может рассматриваться в качестве своеобразного режима стресс-тестирвоания графического ускорителя.

Тестирование производительности графического ускорителя производства NVIDIA с помощью GLMark2: я пользуюсь ноутбуком с дискретным графическим ускорителем NVIDIA Optimus (GeForce GT 540M), поэтому просто не мог не попытаться протестировать производительность этого ускорителя с помощью GLMark2. Я пытался проводить тесты со всеми известными параметрами, но результаты были неизменно-ужасными. Графический ускоритель ни разу не набирал больше 446 баллов, хотя я провел 4 теста; возможно, утилита GLMark2 просто не совместима с аппаратным обеспечением производства NVIDIA.

Команды, которые я использовал для тестирования производительности дискретного графического ускорителя производства NVIDIA с помощью утилиты GLMark2:

optirun glmark2 optirun -vv -b virtualgl -c jpeg glmark2 vblank_mode=0 primusrun glmark2

3. Тест Furmark утилиты GPUTest от команды ресурса geeks3d

Перейдем к рассмотрению инструмента для достоверного тестирования производительности графического ускорителя. Тест Furmark является одним из тестов утилиты с закрытым исходным кодом GPUTest от команды ресурса geek3d, которая может быть бесплатно загружена по ссылке www.geeks3d.com/gputest/download . Следует выибрать версию для Linux, которая распространяется в форме обычного ZIP-архива. В том случае, если вы загрузили этот архив в директорию Загрузки , вам придется выполнить следующую последовательность команд для его распаковки и запуска утилиты:

cd ~/Загрузки/ unzip GpuTest_Linux_x64_0.7.0.zip cd GpuTest_Linux_x64_0.7.0/ ./GpuTest /test=fur /width=800 /height=600 /benchmark

В результате откроется окно разрешением в 800×600 пикселей, с помощью которого будет выводиться сложный трехмерный объект, подобный представленному ниже.

При тестировании производительности графического ускорителя Intel 3000 HD я получил изменяющуюся рывками картинку с 9-10 кадрами в секунду.

И снова я попытался протестировать производительность дискретного графического ускорителя производства компании NVIDIA:

cd ~/Downloads/GpuTest_Linux_x64_0.7.0/ optirun -c jpeg ./GpuTest /test=fur /width=800 /height=600 /benchmark

В этот раз были получены удовлетворительные результаты, выражающиеся в плавно изменяющейся картинке с 18-20 кадрами в секунду.

Стресс-тестирование графического ускорителя с помощью теста Furmark: в результате использования теста Furmark генерируется значительная нагрузка на графический процессор, а с помощью приведенной ниже команды программа может быть запущена в режиме непрерывного тестирования с окном разрешением в 1024×640 пикселей.

./GpuTest /test=fur /width=1024 /height=640

Программа GPUTest содержит реализации большого количества других тестов для тестирования производительности графических ускорителей, полный список которых размещен в файле README.txt. Попробуйте протестировать производительность вашего графического ускорителя с другими параметрами утилиты, пользуясь следующим правилом: чем меньше размер окна, тем больше производительность.

Существуют и другие более функциональные и сложные инструменты для тестирования производительности графических ускорителей от Unigine corp., такие, как Unigine Heaven , Unigine Vally и другие. Я не затрагивал их в данной статье, но вы можете самостоятельно загрузить их по данной ссылке и протестировать производительность своего графического ускорителя.

Если у вас остались вопросы, вы можете задать их и не забудьте поделиться ссылкой на данную статью с друзьями.

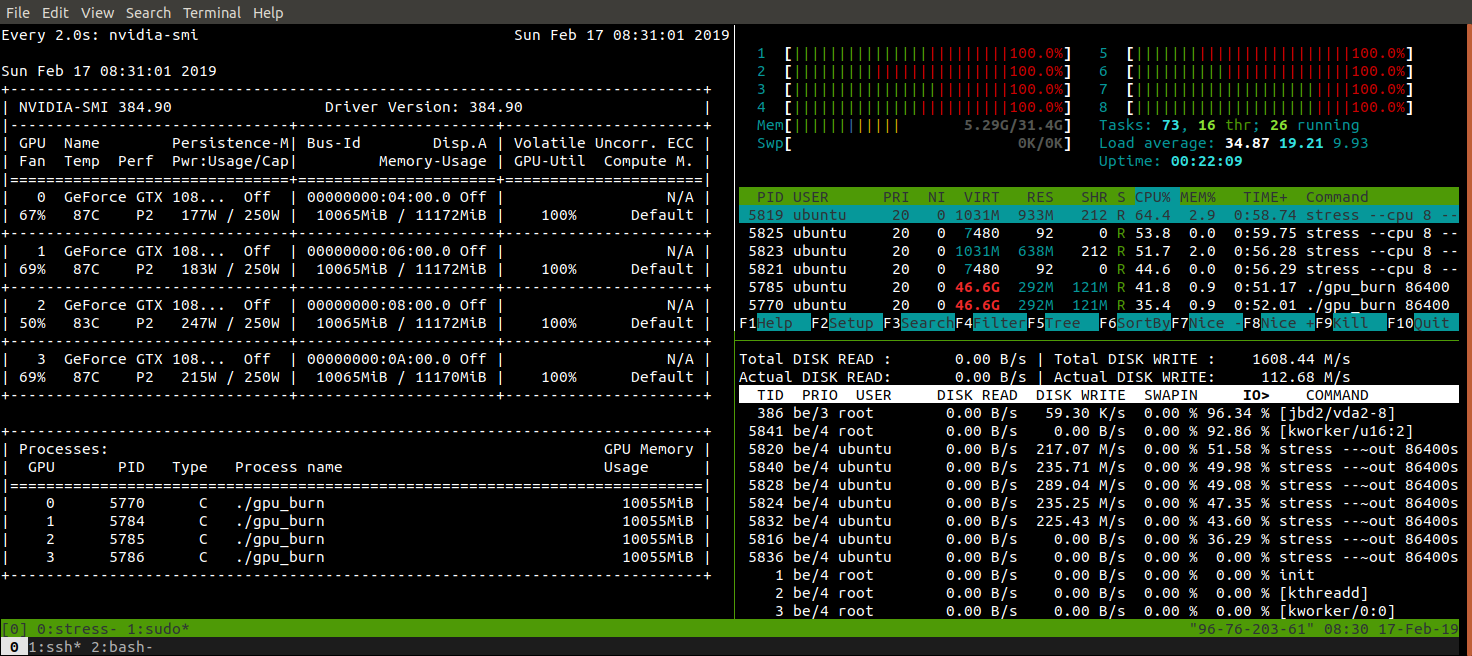

Perform GPU, CPU, and I/O stress testing on Linux

Stephen Balaban February 17, 2019 2 min read

Often times you’ll want to put a system through the paces after it’s been set up. To stress test a system for simultaneous GPU and CPU loads, we’ll use two stress tools: stress and gpu_burn , and three monitoring tools: htop , iotop and nvidia-smi . The easiest way to make your own monitoring tool with the output of a script is with the watch command. This article assumes you have the proper GPU drivers in place, check out Lambda Stack if you need to install CUDA, CuDNN, and the NVIDIA drivers.

Install stress, htop, and iotop

On Ubuntu, you can install stress , htop , and iotop via apt-get .

sudo apt-get install -y stress htop iotop lm-sensors # Run a stress test with `nproc` CPU workers (sqrt) # `nproc` Virtual Memory workers (malloc / free) # `nproc` workers calling (sync) # `nproc` workers writing to disk (write / unlink) # For a total of 60 seconds. stress --cpu `nproc` --vm `nproc` --vm-bytes 1GB --io `nproc` --hdd `nproc` --hdd-bytes 1GB --timeout 60sInstall and run gpu-burn

git clone https://github.com/wilicc/gpu-burn cd gpu-burn make ./gpu_burn 60 # will run gpu_burn for 60 secondsMonitor with htop, nvidia-smi, and sensors.

I like to use tmux to split my terminal and have htop , sudo iotop , watch sudo sensors , and watch nvidia-smi running simultaneously. You can use this to monitor the CPU, memory, I/O bandwidth, and GPU utilization of your system as well as the CPU and GPU temperatures.

This is a great way to ensure your system is working up to spec.

Read On

Lambda Echelon – a turn key GPU cluster for your ML team

Lambda Echelon is a GPU cluster designed for AI. It comes with the.

NVIDIA A40 Deep Learning Benchmarks

NVIDIA ® A40 GPUs are now available on Lambda Scalar servers. In this post, we benchmark the A40.