- ASUS PIKE 6480 Utility Download (Official)

- How to Update PIKE 6480 Device Drivers Quickly & Easily

- Step 1 — Download Your Driver

- Step 2 — Install Your Driver

- How to Open Device Manager

- How to Install a driver from Device Manager

- Recent Help Articles

- Arch Linux

- HPE ProLiant MicroServer Gen10 — мониторинг дисков

- Утилиты для работы с контроллером Marvell

- ESXi web

- ESXi shell

- ESXi Marvell (mvcli)

- Заключение

ASUS PIKE 6480 Utility Download (Official)

The following files are found inside the driver download file.

| Name | Size | Date |

|---|---|---|

| Linux/MRU-4.1.0.8-1.i586.rpm | 18.8 MB | 2 Dec 2008 |

| Linux/MRU-4.1.0.8-1.x86_64.rpm | 21.3 MB | 2 Dec 2008 |

| Linux/history.txt | 423 bytes | 2 Dec 2008 |

How to Update PIKE 6480 Device Drivers Quickly & Easily

Step 1 — Download Your Driver

To get the PIKE 6480 driver, click the green download button above. After you complete your download, move on to Step 2.

If the driver listed is not the right version or operating system, search our driver archive for the correct version. Enter ASUS PIKE 6480 into the search box above and then submit. In the results, choose the best match for your PC and operating system.

Tech Tip: If you are having trouble deciding which is the right driver, try the ASUS Driver Update Utility. It is a software utility which automatically finds and downloads the right driver.

To find the newest driver, you may need to visit the ASUS website. Most major device manufacturers update their drivers regularly.

Step 2 — Install Your Driver

Once you have downloaded your new driver, you’ll need to install it. In Windows, use a built-in utility called Device Manager, which allows you to see all of the devices recognized by your system, and the drivers associated with them.

How to Open Device Manager

- In Windows 11, Windows 10 & Windows 8.1, right-click the Start menu and select Device Manager

- In Windows 8, swipe up from the bottom, or right-click anywhere on the desktop and choose «All Apps» -> swipe or scroll right and choose «Control Panel» (under Windows System section) -> Hardware and Sound -> Device Manager

- In Windows 7, click Start -> Control Panel -> Hardware and Sound -> Device Manager

- In Windows Vista, click Start -> Control Panel -> System and Maintenance -> Device Manager

- In Windows XP, click Start -> Control Panel -> Performance and Maintenance -> System -> Hardware tab -> Device Manager button

How to Install a driver from Device Manager

- Locate the device and model that is having the issue and double-click on it to open the Properties dialog box.

- Select the Driver tab.

- Click the Update Driver button and follow the instructions.

In most cases, you will need to reboot your computer in order for the driver update to take effect.

Tech Tip: Driver downloads and updates come in a variety of file formats with different file extensions. For example, you may have downloaded an EXE, INF, ZIP, or SYS file. Each file type has a slighty different installation procedure to follow.

For more help, visit our Driver Support Page for step-by-step videos on how to install drivers for every file type.

- Updates PC Drivers Automatically

- Identifies & Fixes Unknown Devices

- Supports Windows 11, 10, 8, & 7

Recent Help Articles

Arch Linux

I have an old Lenovo D20 ThinkStation, with a Marvell RAID controller onboard. Here are the details of the RAID controller (out of lspci):

01:00.0 RAID bus controller: Marvell Technology Group Ltd. MV64460/64461/64462 System Controller, Revision B (rev 01) Subsystem: Lenovo MV64460/64461/64462 System Controller, Revision B Control: I/O+ Mem+ BusMaster+ SpecCycle- MemWINV- VGASnoop- ParErr- Stepping- SERR- FastB2B- DisINTx- Status: Cap+ 66MHz- UDF- FastB2B- ParErr- DEVSEL=fast >TAbort- SERR- I downloaded mrvl_utl_msu-4.1.10.2038_linux_x86-64.zip (software for Marvell RAID controllers) off a Lenovo website. but the mvcli utility contained within it doesn't recognize the adapter. Marvell no longer lists this device on their website, and Lenovo has a dearth of resources pertaining to Linux for this ThinkStation. If you know of a Linux utility that can manage this hardware RAID, I wouldn't mind exploring options there.

Until I can find a utility that can manage this particular hardware RAID device, I'm considering constructing a JBOD physical array with a set of five physical disks, as large as I can afford (anywhere from 3T through 12T per disk when I'm ready to purchase). My options then are software RAID, with mdadm or lvmraid. The main reason for software RAID in lieu of OS-managed hardware RAID is I suspect it will be easier to monitor the health of the individual disks with OS-level tools (e.g., smartctl, etc.).

mdadm seems the most straightforward, but lvmraid seems to be the most flexible. I'm seeking comments here: which would you prefer, and why? I plan on purchasing six identical SATA or SAS disks, and use RAID10 on four disks with one hot spare, and one cold (disconnected) spare in case of future disk failure. I'm open to other RAID levels (I have an old QNAP NAS with five 2T disks in software RAID6, and I plan on migrating the data off of that into this new array), but I choose RAID10 as a balance between performance and redundancy (RAID6 reduced my usable capacity from 10T to less than 6T, and I ultimately regretted that decision).

I could also go with an advanced filesystem (such as ZFS or Btrfs). My experience with Btrfs is limited (I've only used it once on a single physical NVMe disk), and I have no experience with ZFS. I had trouble with Btrfs, I don't remember the details but one of the internal structures became unreadable, such that my laptop wouldn't boot. I ended up invalidating the entire filesystem (and losing my home partition) when I tried to recover it. I had been tracking Btrfs stability via the Btrfs mailing list a while ago, and it never appeared to be totally stable for RAID. I know little to nothing about ZFS. My fear is that either of these options aren't stable enough for extended use (I anticipate this RAID array to last 5-6 years).

I may not be building this array for several months. I haven't even figured out my budget for it yet, but I figure I can start planning now.

Marvell Storage Utility on HPE ProLiant MicroServer Gen10

[2019-03-01 Fri] See comment below; some Linux operating systems already provide native support for the Marvell RAID controller in legacy mode.

Marvell SATA controller

Recently I purchased an HPE ProLiant MicroServer Gen10 which comes with the Marvell SATA controller 88SE9230, also called Marvell Storage Utility (MSU). As far as I know, this controller has an ARM chip to provide RAID 0 (non-redundant combination of disks), RAID 1 (straight mirroring) or RAID 10 (a combination of RAID 0 and RAID 1).

Neither Marvell nor HPE do provide drivers for generic Linux systems but they do provide a package for ClearOS which uses the Red Hat Package Manager (RPM).

Initially, I tried to manage the RAID using the Marvell BIOS utility which can be accessed by the EFI shell. The BIOS utility and the user guide can be downloaded from the HPE support center. However, this procedure is slow and complicated, especially if the server is headless, as in my case. Furthermore, monitoring the disks with SMART data is also impossible. So I decided to invest some time in amending the ClearOS package for Arch Linux and provide an AUR package.

Marvell controller package

I had serious trouble running the original scripts and daemons because they are (a) written for ClearOS and (b) expect the generic but outdated SCSI kernel module sg to be loaded. I provide replacements with the same functionality:

- MSUAgent - The MSU Event Manager.

- MSUWebServer - The MSU Web Server (manual access at port 8045).

- MSUStart - A small script to access the web interface.

These scripts also pull the sg module in case it is not loaded.

For my purposes however (I do not need a web interface), the MSU client mvcli , which is located in the folder /opt/marvell/storage/cli is all I need. Don’t forget to manually load the sg module, which sets up the SCSI devices for this script, e.g., with

Then, the SMART data can be retrieved, e.g., with

sudo /opt/marvell/storage/cli/mvcli smart -p 0

In the course of this project, I also stumbled upon other very useful SCSI related software: lsscsi , sg3_utils , sdparm , hdidle .

I am still having trouble with monitoring temperature (e.g., CPU temperature), please leave a note if you know an easy way to achieve this.

HPE ProLiant MicroServer Gen10 — мониторинг дисков

Что-то я обеспокоился состоянием дисков своего домашнего сервера HPE ProLiant MicroServer Gen10. У этого сервера есть одна маленькая, но очень большая проблема — мониторинг состояния дисков и дисковых массивов.

Сразу добавлю, проблему мониторинга в этой статье мы решим.

Поиск в Интернете и на официальном форуме HPE ничего не дал. Люди обеспокоены, но никто не может найти решения. Как-то давно находил статью, где умелец сделал из сервера домашний NAS и в Linux умудрялся вытащить какие-то данные о температуре процессора. Меня сейчас больше всего волнует определение состояния дисков. Я на сервер установил гипервизор ESXi 7, здесь с мониторингом в принципе всё сложно. Если выйдет из строя один диск, то я об этом никак не узнаю.

В сервер можно установить четыре 3.5' диска. Диски можно объединять в RAID массивы, для этого в сервере имеется встроенный контроллер "Marvell 88SE9230 PCIe to SATA 6Gb/s Controller embedded". И очень здорово, что контроллер относится к аппаратным, что позволяет использовать RAID массивы в гипервизоре ESXi.

При желании можно добавить пятый 2.5' диск. Я его использую в качестве системного диска для ESXi 7.

У меня такая конфигурация:

- В пятом SATA слоте установлен 2.5' диск с ос ESXi 7.

- В первом и втором SATA слоте находятся диски, которые объединены в RAID1 на контроллере Marvell. Массив используется как Storage в гипервизоре.

Утилиты для работы с контроллером Marvell

Раньше была отдельная утилита "Marvell BIOS Utility (UEFI) HPE MicroServer Gen10 Server", но теперь она недоступна для скачивания. Нужно обновить BIOS до последней версии, тогда появится возможность настройка RAID в Built-in EFI Shell.

Официально нет, будем исправлять.

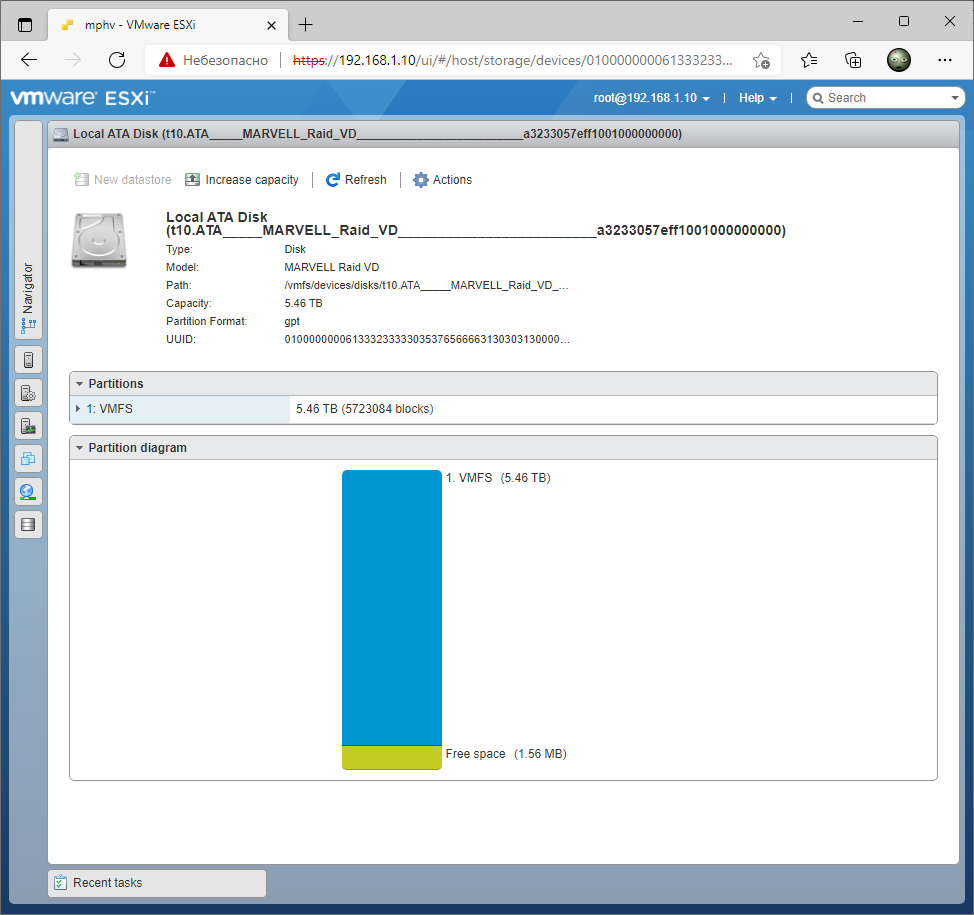

ESXi web

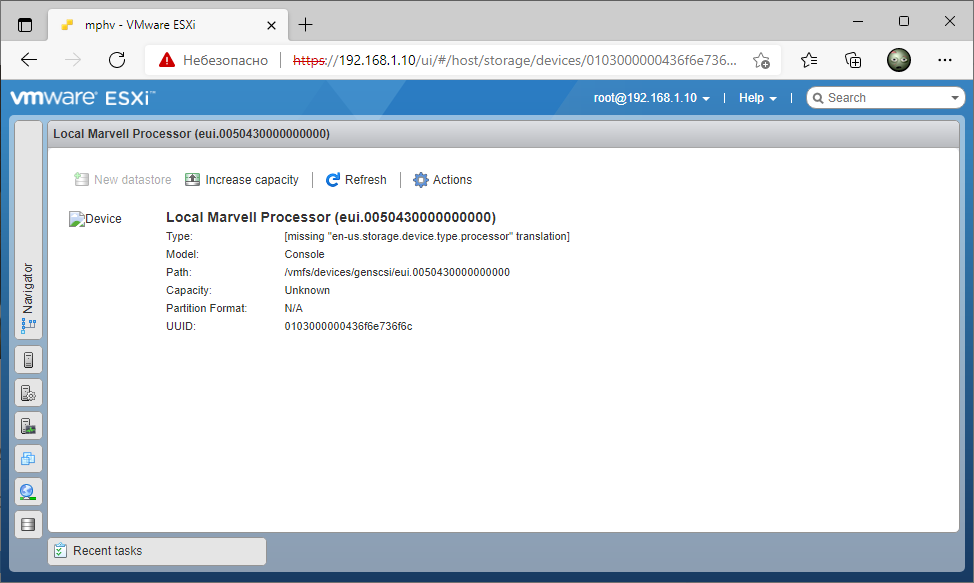

Для начала посмотрим, что можно узнать о дисках в ESXi без дополнительных средств.

В web интерфейсе в хранилище виден Local Marvell Processor.

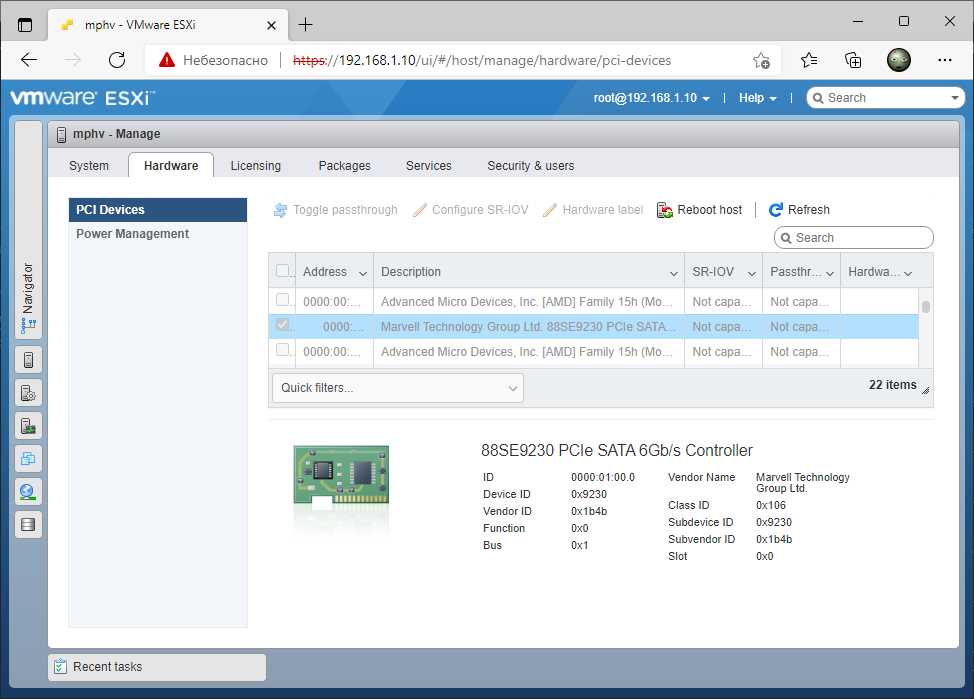

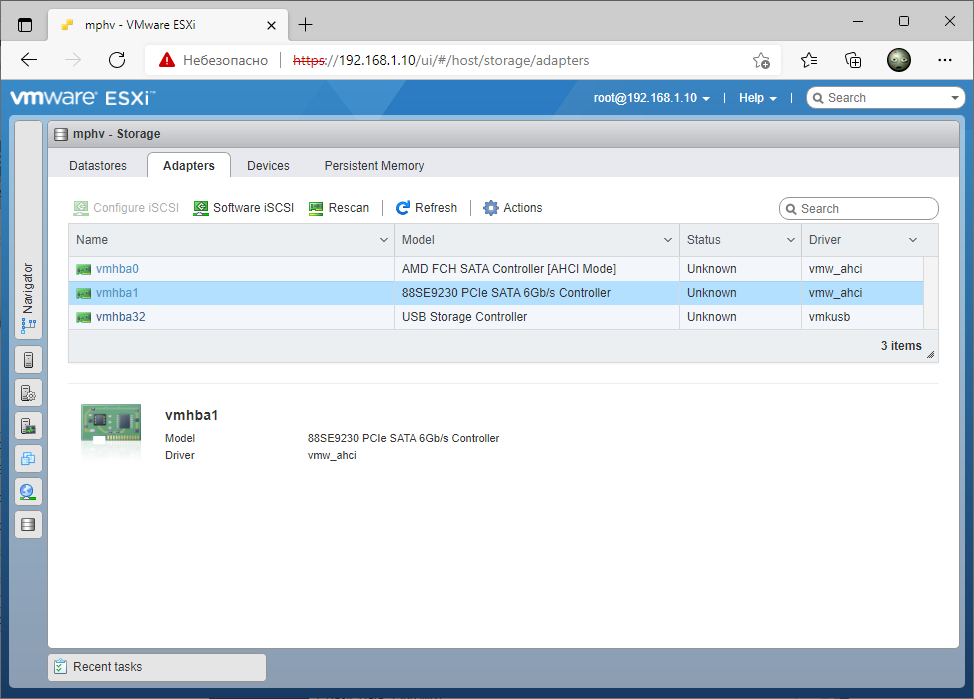

В PCI устройствах отображается контроллер.

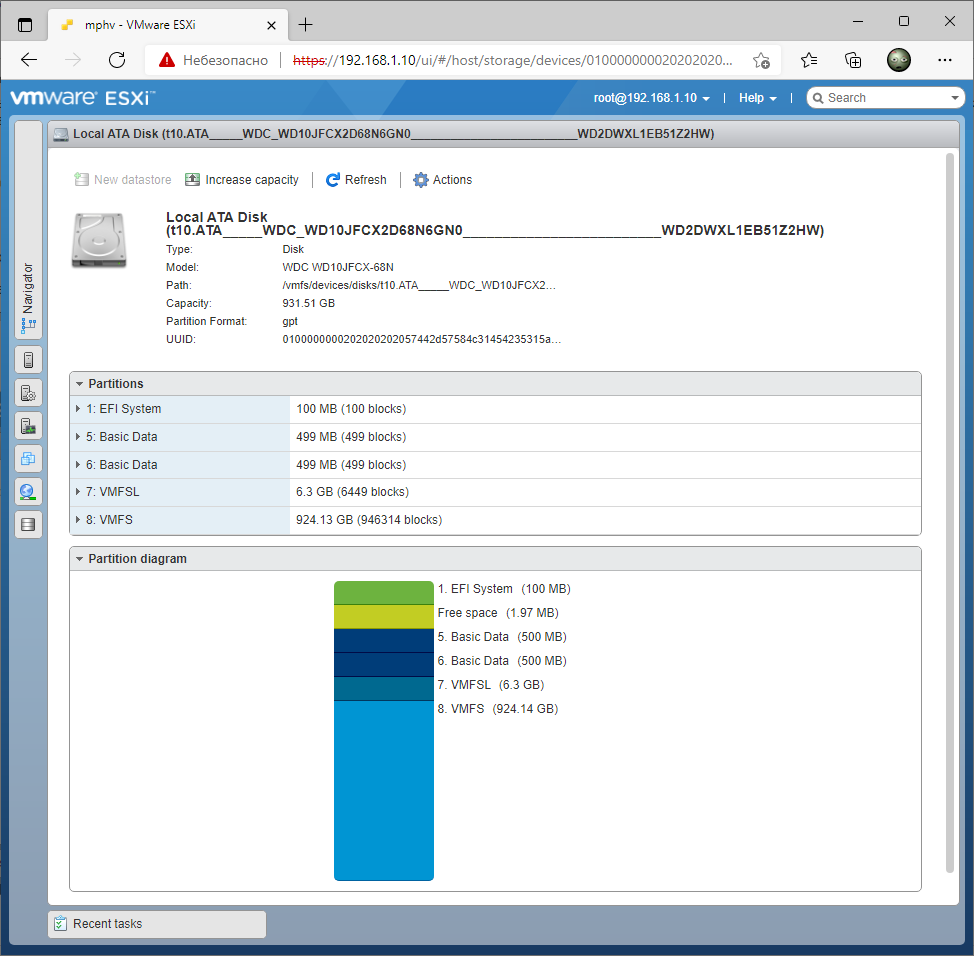

Виден пятый SATA диск. Виден объём. Из названия можно вычленить модель и серийный номер.

Виден RAID1. Отображается общий объём.

Никакой информации о дисках в RAID1 нет.

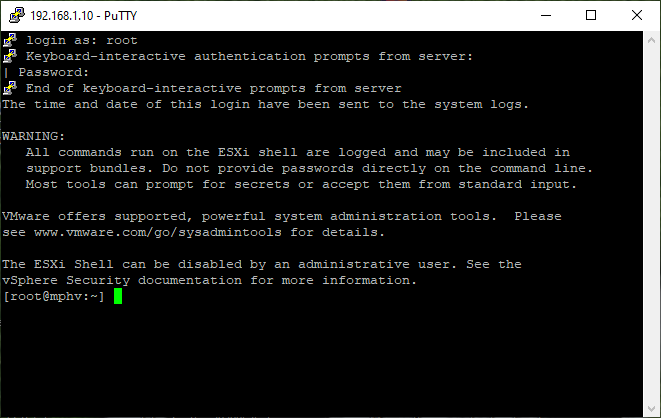

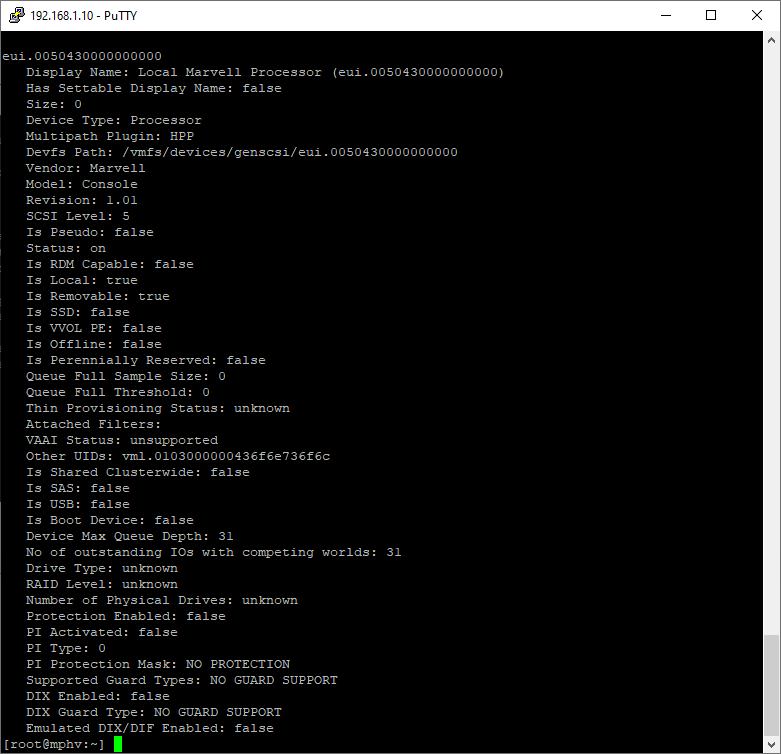

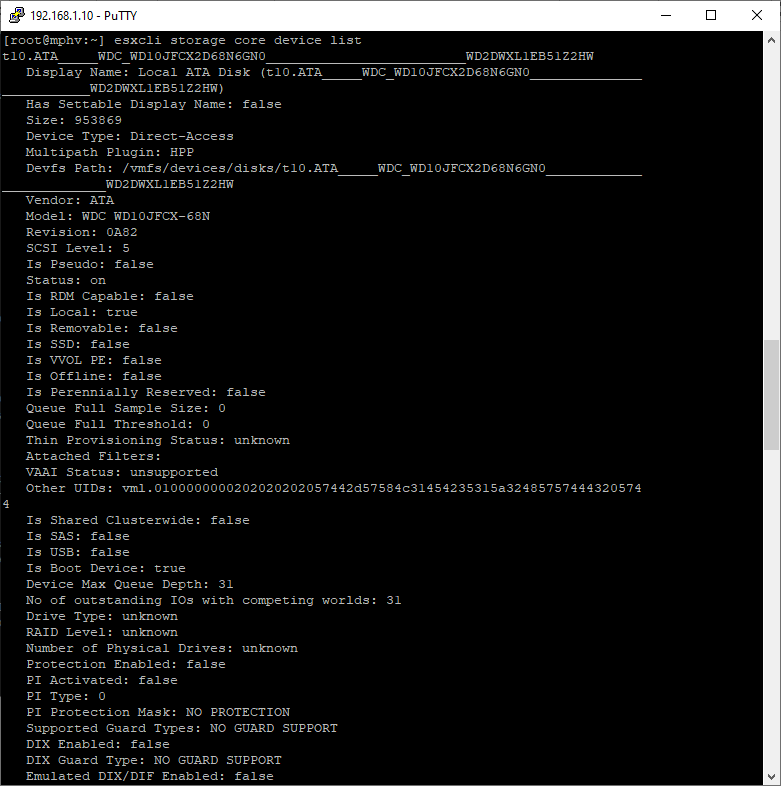

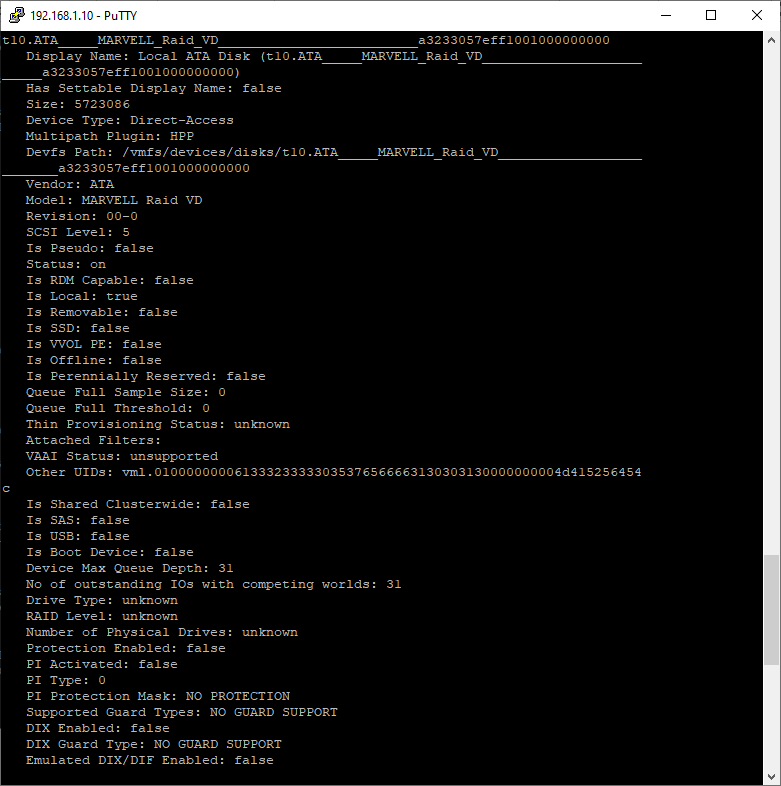

ESXi shell

Здесь можно узнать немного больше информации. Выведем информацию об устройствах хранения:

esxcli storage core device list

Вот наш чип. Для мониторинга дисков информация бесполезна.

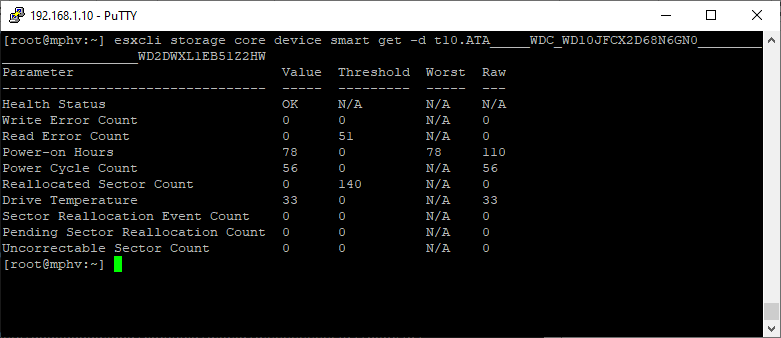

Получим SMART пятого SATA диска:

esxcli storage core device smart get -d t10.ATA_____WDC_WD10JFCX2D68N6GN0_________________________WD2DWXL1EB51Z2HW

Ну вот уже что-то. Видно состояние диска, количество ошибок и температуру диска.

Это максимум того, что я добился с текущими инструментами оболочки ESXi. Доступен только мониторинг пятого SATA диска. Т.е. тех дисков, которые не объединены в RAID массив. Но этого мало.

Следующая идея — найти какой-нибудь VIB пакет, который установит утилиту для работы с контроллером Marvell.

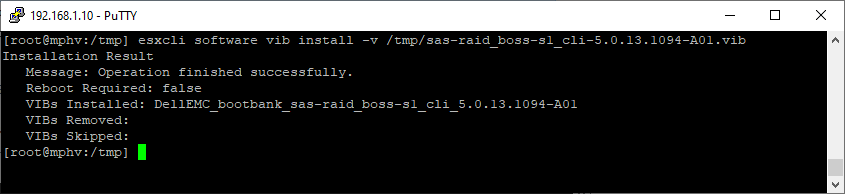

ESXi Marvell (mvcli)

Я не буду рассказывать как я искал утилиту под ESXi для работы с контроллерами Marvell. Но я её нашёл. Утилита называется mvcli.

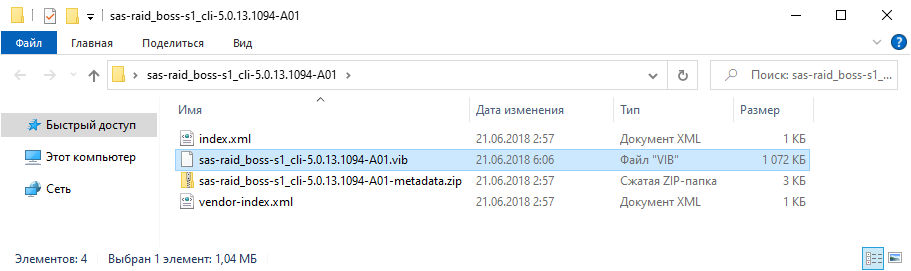

Нам нужен пакет sas-raid_boss-s1_cli-5.0.13.1094-A01.zip. На всякий случай качнул его к себе:

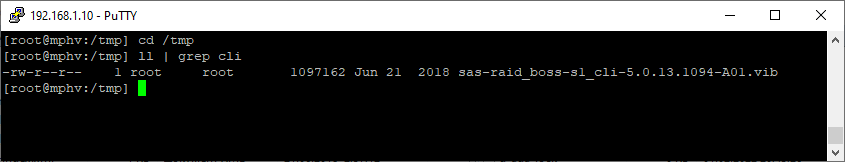

Нас интересует файл sas-raid_boss-s1_cli-5.0.13.1094-A01.vib. Закидываем его на наш гипервизор в /tmp:

esxcli software vib install -v /tmp/sas-raid_boss-s1_cli-5.0.13.1094-A01.vib

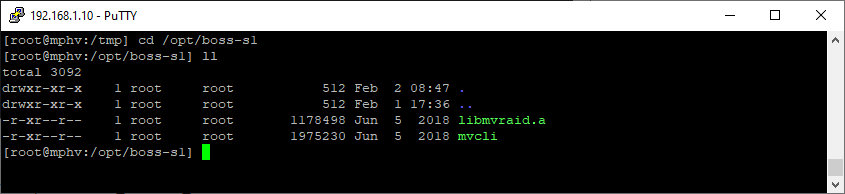

После установки утилиту можно найти в /opt/boss-s1.

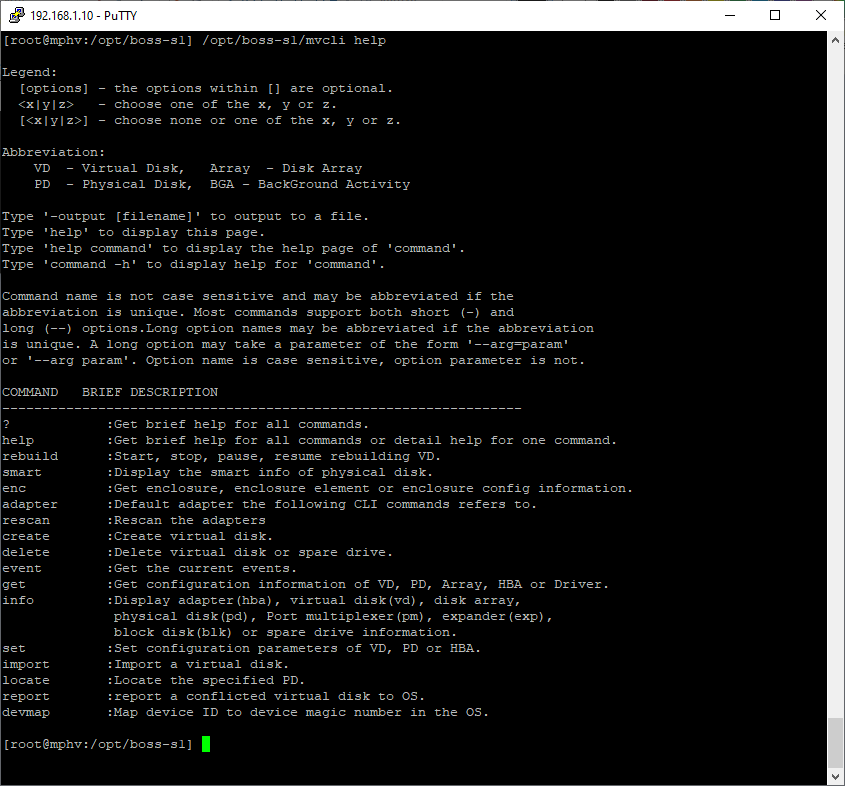

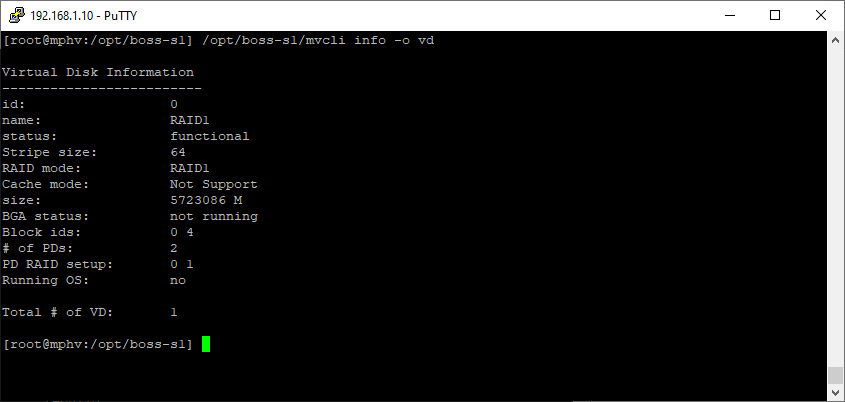

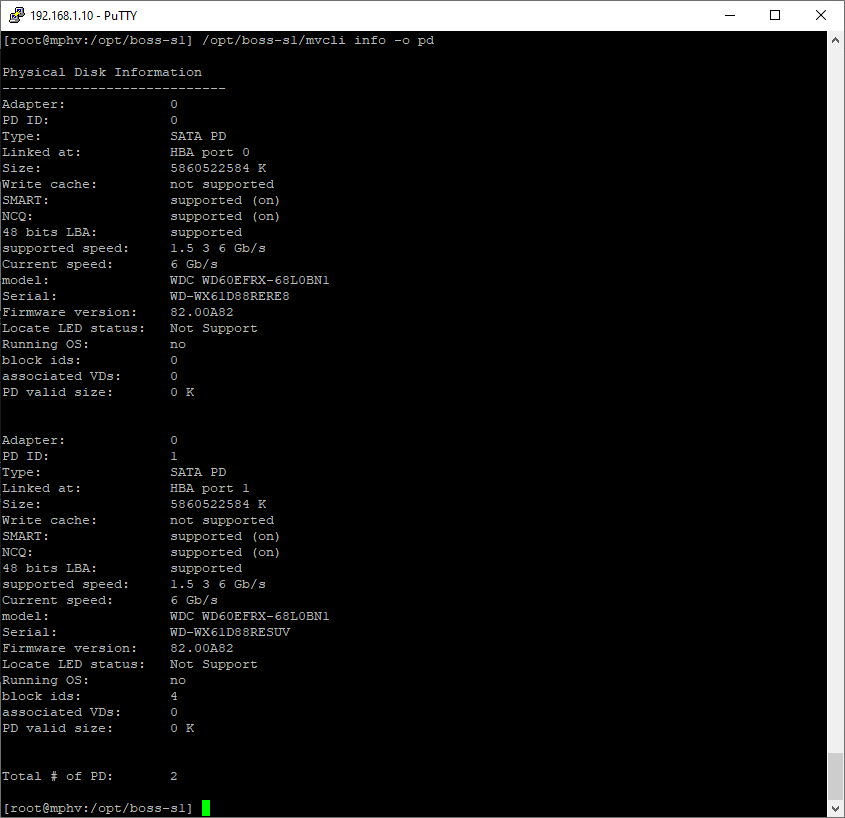

Вот теперь попробуем получить все данные, которые нам нужны.

/opt/boss-s1/mvcli help info /opt/boss-s1/mvcli help get

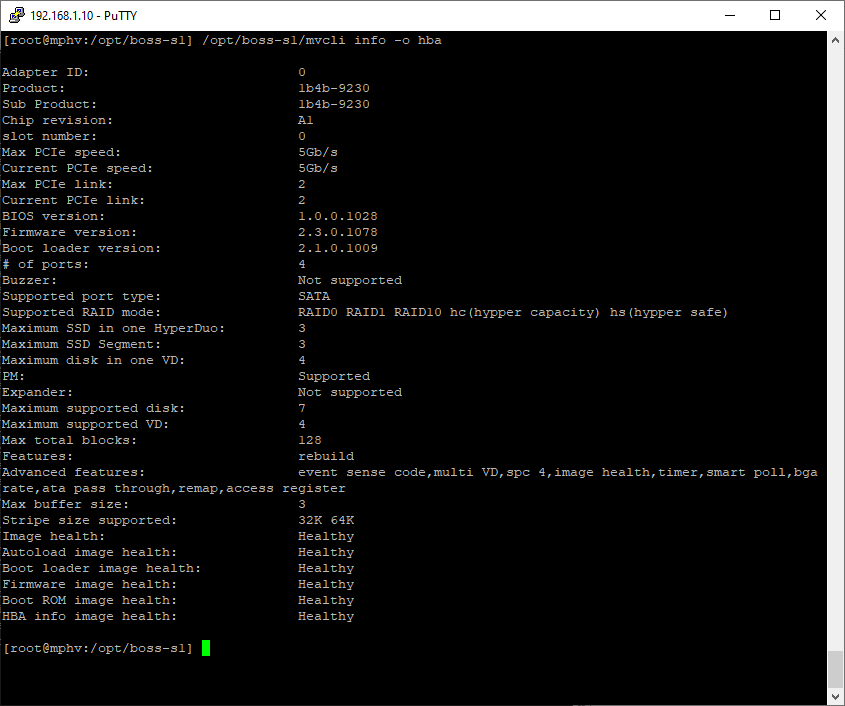

/opt/boss-s1/mvcli info -o hba

Информация о дисках массивов:

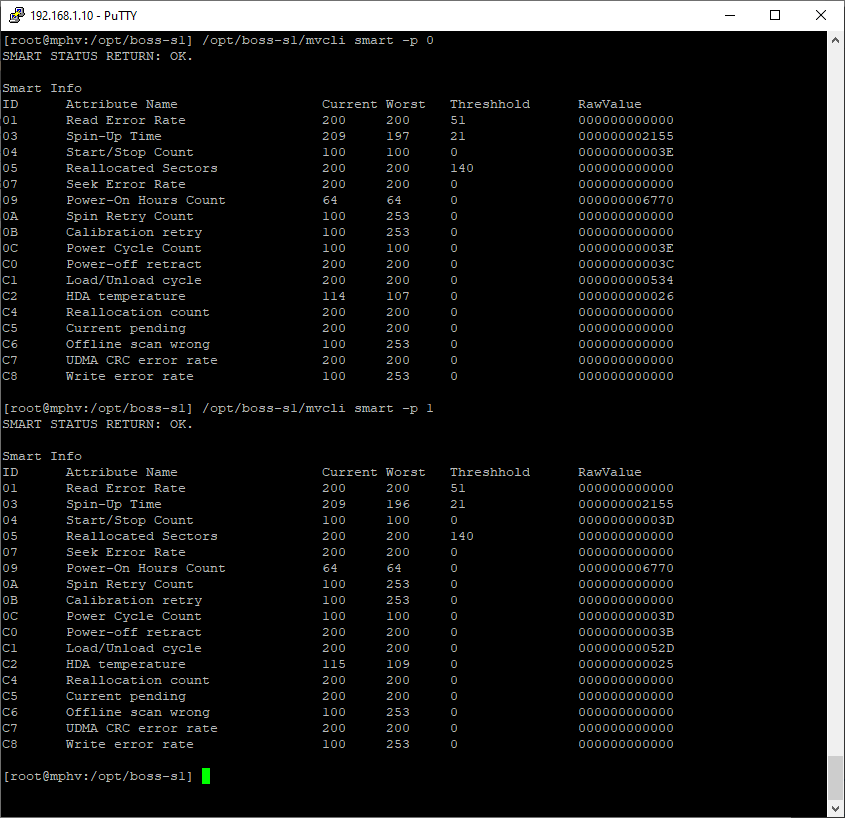

/opt/boss-s1/mvcli smart -p 0 /opt/boss-s1/mvcli smart -p 1

События контроллера (у меня там пусто):

Даже прошивку можно обновить при желании (пока нет желания):

/opt/boss-s1/mvcli flash -a update -f -t raw

Заключение

Нам удалось добраться до SMART всех дисков, получить данные об их состоянии и температуре. Кстати, температура дисков в основной секции всего 25 - 26 °C, совсем не греются. Пятый диск показывает температуру 33 °C, но это тоже отличный показатель.

Дополнительно мы получили состояние RAID массива:

В дальнейшем получение этих данных было бы неплохо автоматизировать, настроить уведомления, график температур. Но это уже совсем другая история и другая задача.