- Установка Astra Linux Smolensk с использованием Linux RAID и UEFI

- Решение проблем

- Работа с mdadm в Linux для организации RAID

- Установка mdadm

- Сборка RAID

- Подготовка носителей

- Создание рейда

- Создание файла mdadm.conf

- Создание файловой системы и монтирование массива

- Информация о RAID

- Проверка целостности

- Восстановление RAID

- Замена диска

- Пересборка массива

- Запасной диск (Hot Spare)

- Добавить диск к массиву

- Удаление массива

Установка Astra Linux Smolensk с использованием Linux RAID и UEFI

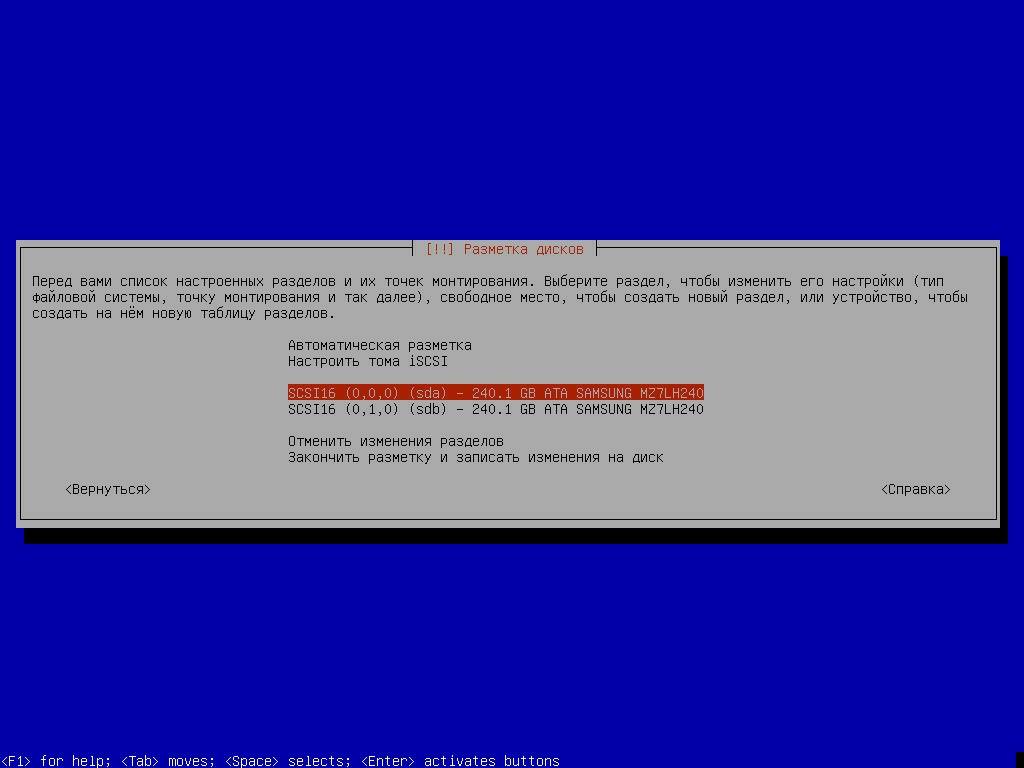

Выбираем ручной метод разметки

Следующие действия производим для каждого физического диска: Выбираем диски и жмем Enter для создания на нем таблицы разделов.

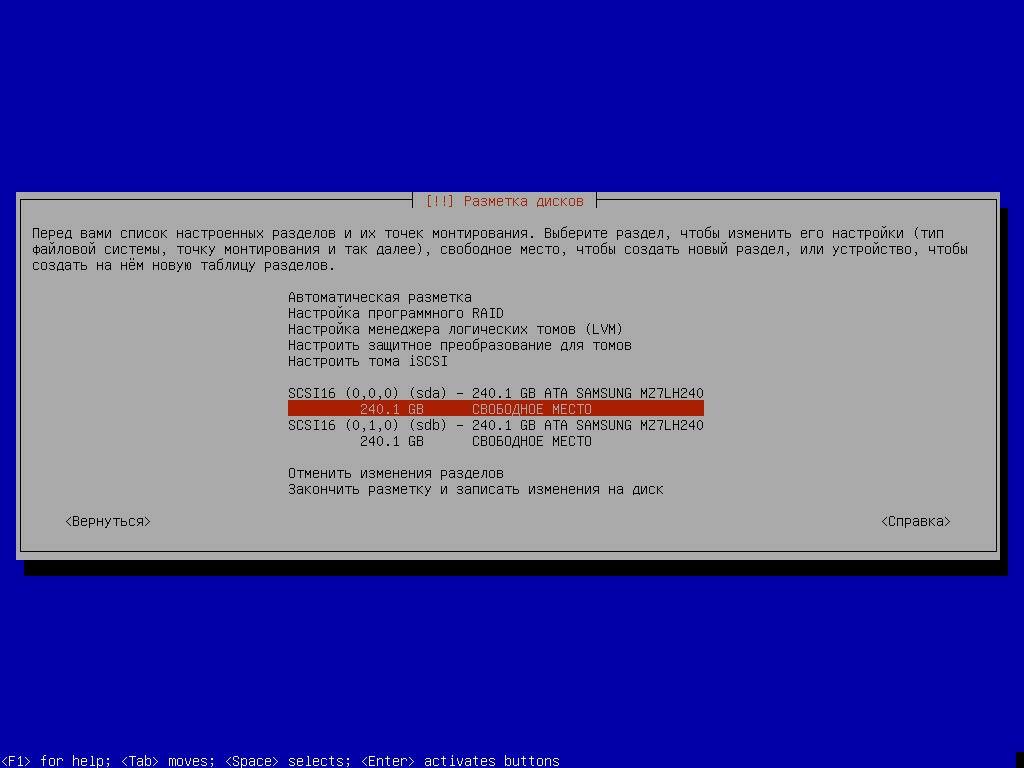

Выбираем свободное место на диске и жмем enter для создания логического раздела.

Указываем объем 1 ГБ .

В начале свободного места.

Изменяем тип раздела, выбрав поле Использовать как: и нажав Enter.

Устанавливаем значение системный раздел EFI

Выбираем свободное место и нажимаем Enter для создания еще одного логического раздела.

Оставляем размер без изменений, чтобы использовать всю свободную емкость диска.

Изменяем тип раздела, выбрав поле Использовать как: и нажав Enter.

Устанавливаем значение физический том для RAID

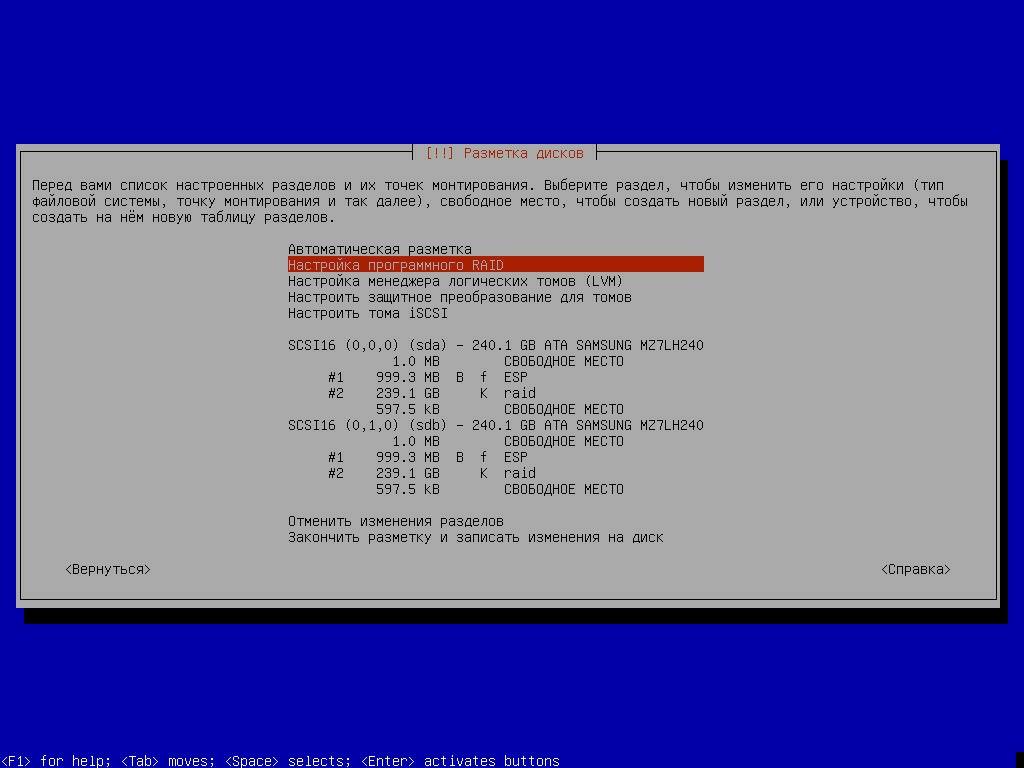

Выбираем раздел меню Настройка программного RAID

Необходимо создать новое устройство MD. Выбираем соответсвующий пункт меню.

Указываем тип — RAID1 для создания зеркального тома.

Число активных дисков оставляем без изменений — 2 .

Число резервных разделов оставляем без изменений — 0 .

Выбираем созданные логические тома типа raid

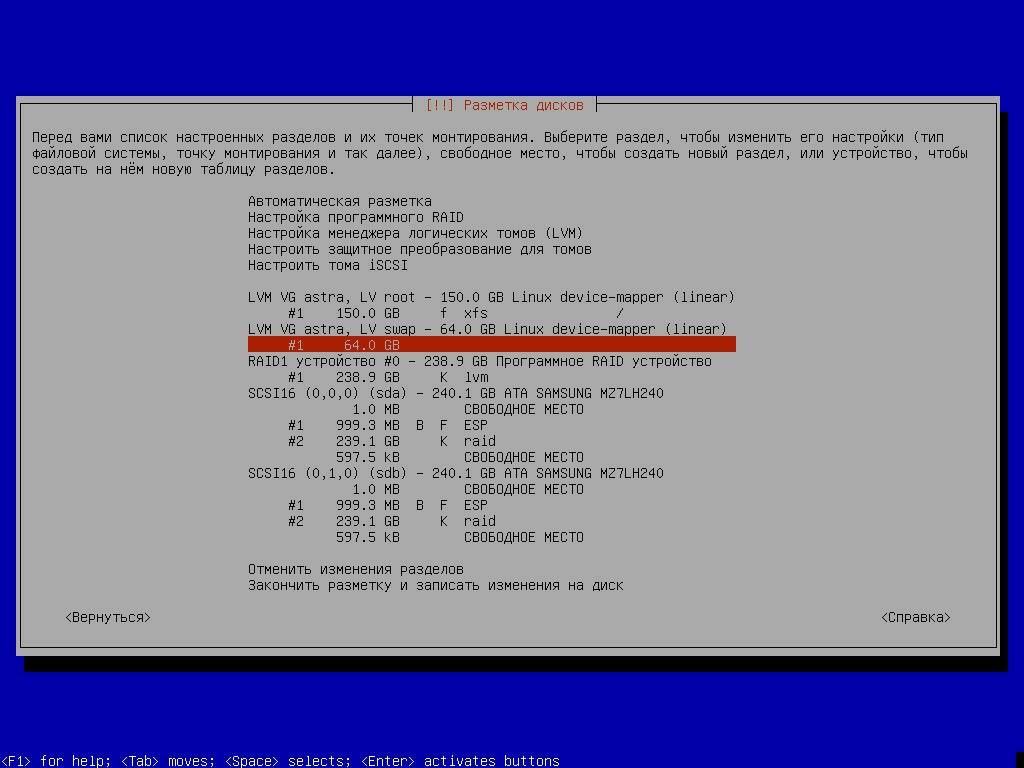

Выбираем свободное место в созданном программном RAID устройстве и нажимаем Enter.

Изменяем тип раздела, выбрав поле Использовать как: и нажав Enter.

Устанавливаем значение физический том для LVM

Выбираем пункт меню Настройка менеджера логических томов LVM

Создаём группу томов

Для создания группы томов используем созданный программный RAID массив /dev/md0

Создаем логический том root. Объем задаём с учетом запаса для непредвиденного расширения, например 150 GB .

Создаем логический том swap. Объем задаём с учетом запаса для непредвиденного расширения, например 64 GB .

Выбираем свободное пространство в логическом томе root и создаем раздел для корневой файловой системы. Файловая система — XFS , точка монтирования — /

Выбираем свободное пространство в логическом томе swap и создаем раздел для файла подкачки.

Настройка разметки дисков на данном этапе завершена. Продолжайте установку ОС, следуя интерфейсу.

Если ОС не загружается — проверьте дату на сервере. Если время откатилось на 2016й год — необходимо загрузиться с установщика, задать актуальную дату, например через консоль alt+F2 , коммандой date -s 2021-07-07 и выполнить чистую установку с нуля.

После установки ОС, необходимо скопировать загрузчик на второй диск и прописать его в качестве варианта загрузки. Выполните следующие действия в консоли.

sudo su dd if=/dev/sda1 of=/dev/sdb1 bs=1M efibootmgr --delete-bootnum -b 0000 efibootmgr --create -d /dev/sdb -p 1 -L "Linux sdb" -l "\efi\astralinuxse\grubx64.efi" efibootmgr --create -d /dev/sda -p 1 -L "Linux sda" -l "\efi\astralinuxse\grubx64.efi"

Проверьте результат перезагрузившись и выбрав пункт меню BIOS — One time boot . В списке устройств доступных для загрузки по UEFI должны отображаться варианты “Linux sdb” и “Linux sda”. Оба режима загрузки должны работать корректно.

Решение проблем

Если что-то идёт не так во время установки — начните сначала с полным удалением всех данных на дисках.

Работа с mdadm в Linux для организации RAID

Обновлено: 23.06.2023 Опубликовано: 08.03.2019

Тематические термины: RAID, Linux mdadm — утилита для работы с программными RAID-массивами различных уровней. В данной инструкции рассмотрим примеры ее использования.

Установка mdadm

Сборка RAID

Подготовка носителей

Сначала необходимо занулить суперблоки на дисках, которые мы будем использовать для построения RAID (если диски ранее использовались, их суперблоки могут содержать служебную информацию о других RAID):

* в данном примере мы зануляем суперблоки для дисков sdb и sdc. Если мы получили ответ:

mdadm: Unrecognised md component device — /dev/sdb

mdadm: Unrecognised md component device — /dev/sdc

. то значит, что диски не использовались ранее для RAID. Просто продолжаем настройку. Далее нужно удалить старые метаданные и подпись на дисках:

Создание рейда

- /dev/md0 — устройство RAID, которое появится после сборки;

- -l 1 — уровень RAID;

- -n 2 — количество дисков, из которых собирается массив;

- /dev/sd — сборка выполняется из дисков sdb и sdc.

Мы должны увидеть что-то на подобие:

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store ‘/boot’ on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

—metadata=0.90

mdadm: size set to 1046528K

Также система задаст контрольный вопрос, хотим ли мы продолжить и создать RAID — нужно ответить y:

Continue creating array? y

Мы увидим что-то на подобие:

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md0 started.

. и находим информацию о том, что у наших дисков sdb и sdc появился раздел md0, например:

.

sdb 8:16 0 2G 0 disk

??md0 9:0 0 2G 0 raid1

sdc 8:32 0 2G 0 disk

??md0 9:0 0 2G 0 raid1

.

* в примере мы видим собранный raid1 из дисков sdb и sdc.

Создание файла mdadm.conf

В файле mdadm.conf находится информация о RAID-массивах и компонентах, которые в них входят. Для его создания выполняем следующие команды:

echo «DEVICE partitions» > /etc/mdadm/mdadm.conf

mdadm —detail —scan —verbose | awk ‘/ARRAY/ ‘ >> /etc/mdadm/mdadm.conf

DEVICE partitions

ARRAY /dev/md0 level=raid1 num-devices=2 metadata=1.2 name=proxy.dmosk.local:0 UUID=411f9848:0fae25f9:85736344:ff18e41d

* в данном примере хранится информация о массиве /dev/md0 — его уровень 1, он собирается из 2-х дисков.

Создание файловой системы и монтирование массива

Создание файловой системы для массива выполняется также, как для раздела, например:

* данной командой мы создаем на md0 файловую систему ext4.

* для файловой системы xfs.

Примонтировать раздел можно командой:

* в данном случае мы примонтировали наш массив в каталог /mnt.

Чтобы данный раздел также монтировался при загрузке системы, добавляем в fstab.

Сначала смотрим идентификатор раздела:

Мы увидим что-то на подобие:

/dev/md0: UUID=»ffa7c082-7613-4dbc-ae62-3f5508652cf6″ TYPE=»ext4″

* в моем примере мы будем использовать идентификатор ffa7c082-7613-4dbc-ae62-3f5508652cf6.

Открываем теперь fstab и добавляем строку:

UUID=»ffa7c082-7613-4dbc-ae62-3f5508652cf6″ /mnt ext4 defaults 0 0

Если ранее мы монтировали раздел в каталог /mnt, вводим:

Мы должны увидеть примонтированный раздел md, например:

/dev/md0 990M 2,6M 921M 1% /mnt

Информация о RAID

Посмотреть состояние всех RAID можно командой:

В ответ мы получим что-то на подобие:

md0 : active raid1 sdc[1] sdb[0]

1046528 blocks super 1.2 [2/2] [UU]

* где md0 — имя RAID устройства; raid1 sdc[1] sdb[0] — уровень избыточности и из каких дисков собран; 1046528 blocks — размер массива; [2/2] [UU] — количество юнитов, которые на данный момент используются.

** мы можем увидеть строку md0 : active(auto-read-only) — это означает, что после монтирования массива, он не использовался для записи.

Подробную информацию о конкретном массиве можно посмотреть командой:

* где /dev/md0 — имя RAID устройства.

Version : 1.2

Creation Time : Wed Mar 6 09:41:06 2019

Raid Level : raid1

Array Size : 1046528 (1022.00 MiB 1071.64 MB)

Used Dev Size : 1046528 (1022.00 MiB 1071.64 MB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Wed Mar 6 09:41:26 2019

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Consistency Policy : resync

Name : proxy.dmosk.local:0 (local to host proxy.dmosk.local)

UUID : 304ad447:a04cda4a:90457d04:d9a4e884

Events : 17

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

- Version — версия метаданных.

- Creation Time — дата в время создания массива.

- Raid Level — уровень RAID.

- Array Size — объем дискового пространства для RAID.

- Used Dev Size — используемый объем для устройств. Для каждого уровня будет индивидуальный расчет: RAID1 — равен половине общего размера дисков, RAID5 — равен размеру, используемому для контроля четности.

- Raid Devices — количество используемых устройств для RAID.

- Total Devices — количество добавленных в RAID устройств.

- Update Time — дата и время последнего изменения массива.

- State — текущее состояние. clean — все в порядке.

- Active Devices — количество работающих в массиве устройств.

- Working Devices — количество добавленных в массив устройств в рабочем состоянии.

- Failed Devices — количество сбойных устройств.

- Spare Devices — количество запасных устройств.

- Consistency Policy — политика согласованности активного массива (при неожиданном сбое). По умолчанию используется resync — полная ресинхронизация после восстановления. Также могут быть bitmap, journal, ppl.

- Name — имя компьютера.

- UUID — идентификатор для массива.

- Events — количество событий обновления.

- Chunk Size (для RAID5) — размер блока в килобайтах, который пишется на разные диски.

Подробнее про каждый параметр можно прочитать в мануале для mdadm:

Также, информацию о разделах и дисковом пространстве массива можно посмотреть командой fdisk:

Проверка целостности

Для проверки целостности вводим:

echo ‘check’ > /sys/block/md0/md/sync_action

Результат проверки смотрим командой:

* если команда возвращает 0, то с массивом все в порядке.

echo ‘idle’ > /sys/block/md0/md/sync_action

Восстановление RAID

Рассмотрим два варианта восстановлении массива.

Замена диска

В случае выхода из строя одного из дисков массива, команда cat /proc/mdstat покажет следующее:

Personalities : [raid1]

md0 : active raid1 sdb[0]

1046528 blocks super 1.2 [2/1] [U_]

* о наличии проблемы нам говорит нижнее подчеркивание вместо U — [U_] вместо [UU].

.

Update Time : Thu Mar 7 20:20:40 2019

State : clean, degraded

.

* статус degraded говорит о проблемах с RAID.

Для восстановления, сначала удалим сбойный диск, например:

mdadm /dev/md0 —remove /dev/sdc

Если нам нужно заменить диск, но при этом он в mdadm имеет рабочее состояние, мы получим ошибку:

Сначала, нам нужно пометить диск как сбойный:

mdadm /dev/md0 —manage —fail /dev/sdc

* в данном примере диск sdb массива md0 будет помечен сбойным.

Теперь удаляем:

mdadm /dev/md0 —remove /dev/sdc

Смотрим состояние массива:

.

Update Time : Thu Mar 7 20:57:13 2019

State : clean, degraded, recovering

.

Rebuild Status : 40% complete

.

* recovering говорит, что RAID восстанавливается; Rebuild Status — текущее состояние восстановления массива (в данном примере он восстановлен на 40%).

Если синхронизация выполняется слишком медленно, можно увеличить ее скорость. Для изменения скорости синхронизации вводим:

echo ‘10000’ > /proc/sys/dev/raid/speed_limit_min

* по умолчанию скорость speed_limit_min = 1000 Кб, speed_limit_max — 200000 Кб. Для изменения скорости, можно поменять только минимальную.

Пересборка массива

Если нам нужно вернуть ранее разобранный или развалившийся массив из дисков, которые уже входили в состав RAID, вводим:

* данная команда сама найдет необходимую конфигурацию и восстановит RAID.

Также, мы можем указать, из каких дисков пересобрать массив:

mdadm —assemble /dev/md0 /dev/sdb /dev/sdc

Запасной диск (Hot Spare)

Если в массиве будет запасной диск для горячей замены, при выходе из строя одного из основных дисков, его место займет запасной.

Диском Hot Spare станет тот, который просто будет добавлен к массиву:

Информация о массиве изменится, например:

.

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

2 8 48 1 active sync /dev/sdc

Проверить работоспособность резерва можно вручную, симулировав выход из строя одного из дисков:

.

Rebuild Status : 37% complete

.

Number Major Minor RaidDevice State

3 8 32 0 spare rebuilding /dev/sdd

2 8 48 1 active sync /dev/sdc

* как видим, начинается ребилд. На замену вышедшему из строя sdb встал hot-spare sdd.

Добавить диск к массиву

В данном примере рассмотрим вариант добавления активного диска к RAID, который будет использоваться для работы, а не в качестве запасного.

Новый диск мы увидим в качестве spare:

mdadm -G /dev/md0 —raid-devices=3

* в данном примере подразумевается, что у нас RAID 1 и мы добавили к нему 3-й диск.

Удаление массива

При удалении массива внимателнее смотрите на имена массива и дисков и подставляйте свои значения.

Если нам нужно полностью разобрать RAID, сначала размонтируем и остановим его:

* где /mnt — каталог монтирования нашего RAID.

Если мы получим ошибку umount: /mnt: target is busy, то смотрим пользовательские процессы, которые мешают отмонтировать раздел:

* где /dev/md0 — массив, который мы хотим разобрать.

Если мы получим ошибку mdadm: fail to stop array /dev/md0: Device or resource busy, с помощью команды

. смотрим процессы, которые используют раздел и останавливаем их.

Затем очищаем суперблоки на всех дисках, из которых он был собран:

mdadm —zero-superblock /dev/sdb

mdadm —zero-superblock /dev/sdc

mdadm —zero-superblock /dev/sdd

* где диски /dev/sdb, /dev/sdc, /dev/sdd были частью массива md0.

А также удаляем метаданные и подпись: